LORA:大模型轻量级微调

Jan 21, 2025 · LORA是一种轻量级的大模型微调方法,旨在减少计算资源消耗并提高适应新任务的效率。

使用lora进行llm微调的数据集应该怎么写? - 知乎

LoRA微调的实用技巧 在使用LoRA(低秩适应)进行大型语言模型(LLM)微调时,有几个实用技巧可以帮助提高效率并节省计算资源和内存。 LoRA的核心思想是通过冻结模型的原始权重, …

大模型轻量级微调(LoRA):训练速度、显存占用分析

Jan 21, 2025 · LoRA 模型的权重、梯度、优化器状态都需要存储,这是毫无疑问的。 结论:LoRA在显存方面就只是节省了主干模型的优化器状态。 另外,实际使用中,我们可以利用 …

高效参数微调方法lora微调矩阵旁路矩阵A和B为什么要这么初始化 …

最近在学习lora的原理,发现降维矩阵A使用随机高斯分布初始化,而升维矩阵B使用0矩阵初始化。为什么要这…

LoRA中初始化 A!=0、B=0,反过却不行吗? - 知乎

LoRA的核心是通过低秩矩阵A和B对预训练模型的权重W进行微调,即W=W0 +A×B(其中A∈Rd×r,B∈Rr×d,r…

LoRA这种微调方法和全参数比起来有什么劣势吗? - 知乎

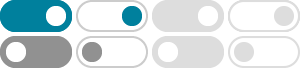

LoRA 架构变化示意图 背景 大型语言模型(LLMs)虽然在适应新任务方面取得了长足进步,但它们仍面临着巨大的计算资源消耗,尤其在复杂领域的表现往往不尽如人意。为了缓解这一问 …

在comfyui中,如何加载多个lora,但不混用,顺次使用? - 知乎

Dec 16, 2024 · 在comfyui中,如何加载多个lora,但不混用,顺次使用? 请问我想在工作流里加载多个lora,但每次成图只使用其中一个,然后把所有lora遍历一遍,这个要如何操作。 比如我 …

ai lora训练眼睛总是崩坏怎么办? - 知乎

ai lora训练眼睛总是崩坏怎么办? 从网上搜教程一步步做,其他都没有问题,但是角色眼睛总是崩坏例如程漩涡状粘在眼皮上 ,我看别人的lora也会有这种问题,但是不知道为什么他们用了某 …

lora 模型的运作原理是怎样的? - 知乎

LoRa模型选择了一些关键层,这些层对于模型的输出具有重要影响。 这些关键层通常是模型中的某些变换器(Transformer)层。 在选定的关键层上,LoRa模型会添加一些额外的LoRa层。 …

如何理解LoRa技术,有哪些应用? - 知乎

LoRa一经推出,就凭借它惊人的灵敏度(-148dbm)、强悍的抗干扰能力、出色的系统容量表现,赢得了广泛的关注。 说白了,LoRa改变了传输功耗和传输距离之间的平衡,彻底改变了嵌 …